一项受神经科学启发的模型架起了生物学与人工智能的桥梁,展现出如何用进化论的设计教会机器更人类化地感知世界。

利物浦大学开发的新型计算机模型能像人脑一样整合视觉与听觉信息。这个源自生物灵感的模型有望塑造下一代人工智能,让机器以更自然的方式感知世界。该模型借鉴了首次在昆虫中发现的大脑功能——这种功能帮助它们探测运动。利物浦大学高级心理学讲师切萨雷·帕里塞博士将这种机制应用于处理现实生活中的视听信号(如视频和声音),取代了旧模型依赖的抽象参数。

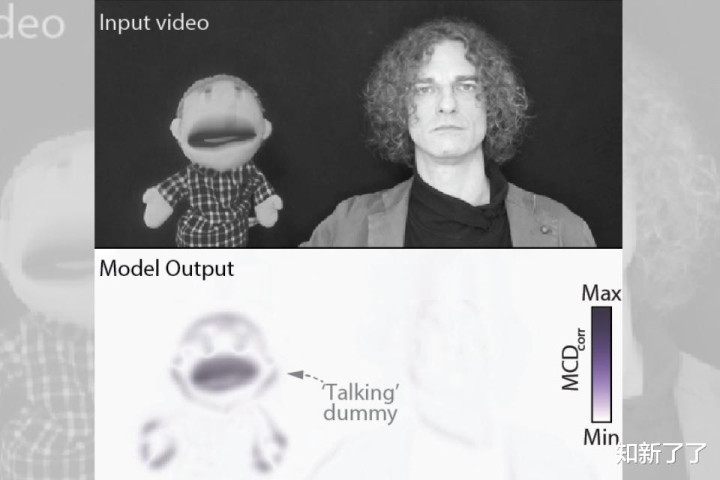

当人类观看说话场景时,大脑会自动关联所见与所闻。这种同步性解释了诸如「麦格克效应」(声音与唇形不匹配会产生新知觉)或「口技表演者错觉」(声音似乎来自木偶)等现象。帕里塞的研究旨在解答「大脑如何判断声音与画面是否匹配」这一核心问题。过去的计算模型无法直接处理这项任务。帕里塞表示:“尽管历经数十年视听感知研究,我们仍缺乏能完成如此简单任务的模型 —— 输入视频后判断音频是否会被感知为同步。”他补充说,这一缺陷折射出更深层问题:若无法直接计算真实刺激,感知模型虽能理论自洽,却无法通过简单的现实测试。

匹配人类与动物行为

新系统基于帕里塞与德国比勒菲尔德大学马克·恩斯特的早期研究。他们提出「关联检测原理」作为大脑融合感官信号的潜在解释,由此催生的「多感官关联检测器」能模拟人类对简单视听模式(如闪光与咔嗒声)的反应。在最新研究中,帕里塞模拟了遍布视听空间的检测器网格,使模型能处理复杂的真实世界信号。

该模型重现了涉及人类、猴子和大鼠的69项著名实验结论。帕里塞指出:“这是该领域迄今最大规模的模拟实验。虽有过往模型经过广泛测试,但从未有研究能一次性验证如此多的数据集。”在使用相同可调参数的情况下,该模型不仅跨物种复现行为规律,甚至超越了主流贝叶斯因果推理模型的表现。它还能预测人类观看视听场景时的注视焦点,充当轻量级「显著性模型」。

迈向更优的AI感知

帕里塞认为模型的简洁性使其在神经科学之外更具价值:“进化早已通过简单通用的计算解决了视听对齐问题,这种计算能跨物种和情境扩展。”由于模型直接处理原始视听输入,可应用于任何现实素材。帕里塞强调:“当前AI系统仍难以可靠整合多模态信息。现有视听模型依赖参数庞大的网络,需在海量标注数据上训练,而多感官关联检测器网格不仅高效且无需训练。”

帕里塞总结道:“这个始于昆虫运动视觉的模型,如今揭示了人类及其他生物的大脑如何在不同情境下整合声音与视觉。从预测麦格克效应到推断因果关系,再到生成动态视听显著性图谱,它为神经科学与人工智能研究提供了新蓝图。”

该研究已发表于《eLife》期刊。

正规股票配资官网网址,股票配资平台安全,杠杆炒股在哪里申请提示:文章来自网络,不代表本站观点。